一、Nunchaku Kontext介绍

开源生态速度就是快啊,Kontext刚开源没几天,各种模型、lora、以及加速模型都来了,今天介绍的是我们熟悉的双截棍Nunchaku,也支持了Kontext了,我第一时间就去更新测试了,真的爽,10秒出图,显存占用16G。

测试了一些数据,发现效果没差多少,速度快了几倍,还是很爽的,废话不多少说,带大家来安装体验最新的Nunchaku。

二、相关安装

以前安装Nunchaku0.2或者Nunchaku0.3版本都要卸载重新安装最新版:Nunchaku0.3.1(版本号,目前最新的就是 3.1 了)

插件地址:https://github.com/mit-han-lab/ComfyUI-nunchaku

轮子安装:

https://modelscope.cn/models/Lmxyy1999/nunchaku/files

comfyui环境:torch2.7和python 3.12,我下载的是 nunchaku-0.3.1+torch2.7-cp312-cp312-win_amd64.whl

nunchaku-0.3.1+torch2.7(Python 版本)-cp312(Python 版本)-cp312-win(操作系统,win/linux)_amd64.whl 大家根据自己的环境下载对应的版本即可

放到comfyUI的python目录下,进入命令窗口执行:

python.exe -m pip install nunchaku-0.3.1-torch2.7-cp312-cp312-win_amd64.whl

到此,环境就安装好了。

模型下载:

这次的模型有2个

- svdq-fp4_r32-flux.1-kontext-dev.safetensors :50系列使用

- svdq-int4_r32-flux.1-kontext-dev.safetensors:50以下系列使用

kontext模型安装路径: models/diffusion_models

CLIP、VAE模型与Flux一致,可重用本地已有模型。

三、使用教程与体验

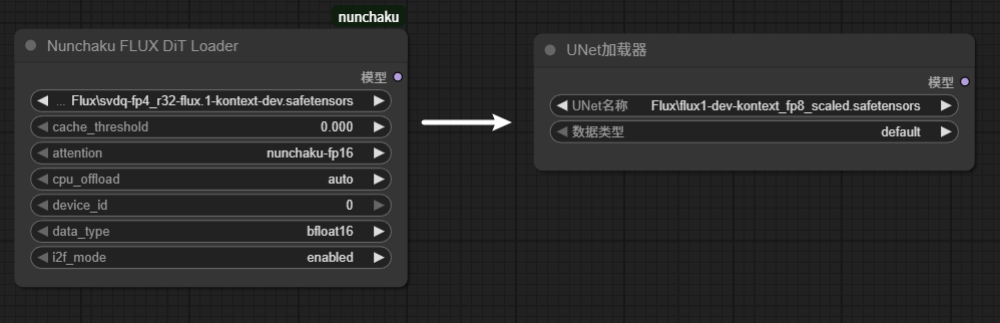

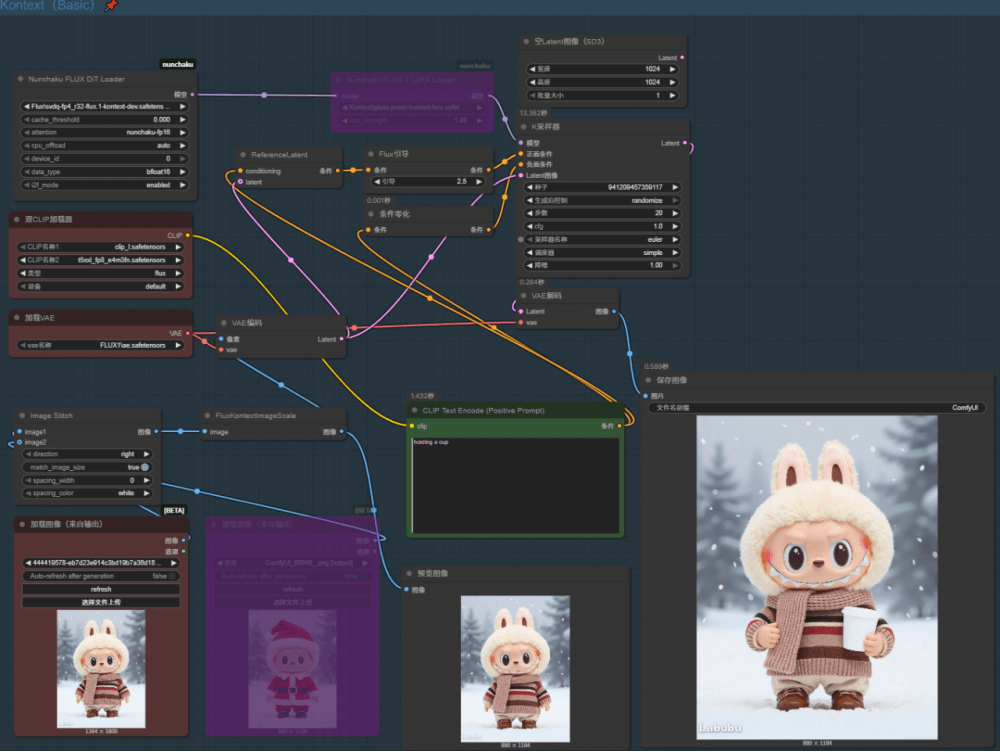

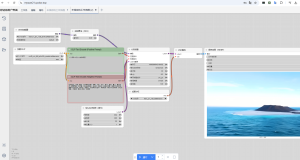

使用方式:工作流与官方默认方式几乎一致,只需将原先的「UNet 加载器」替换为「Nunchaku FLUX DiT Loader」即可无缝运行。

工作流直接使用kontext即可无缝衔接加速,工作流接入Nunchaku示例:

![[绘画教程] Comfyui,最强图片编辑模型轻松脱衣,支持50系列显卡-AIGC VIP部落](http://aigc.vvipblog.net/wp-content/uploads/2025/07/1752548383-61cd49faf155bb2-300x188.png)

暂无评论内容