动作模仿转绘一直是AI视频领域一个重要的方向,之前已经有多个厂家和科研所推出了对应的模型。企鹅家也不甘落后,推出了自己的MimicMotion。

项目和模型介绍

High-Quality Human Motion Video Generation with Confidence-aware Pose Guidance,从英文全称可以看到,它是通过自信度感知的姿态引导模型生成的。它旨在通过自信度感知姿态引导生成高质量的人体运动视频。该框架能够根据任意运动指导生成任意长度的视频,具有丰富的细节和良好的时间连续性。其创新之处在于自信度感知的姿态引导、区域损失放大和渐进潜在融合策略,这些技术显著提高了视频生成的质量和速度。

项目使用了三个模型

- SVD模型,用于将静态图像生成视频,特别适用于生成高质量的图像到视频转换。https://huggingface.co/stabilityai/stable-video-diffusion-img2vid-xt-1-1

- 姿态感知模型 DWPose 模型

- :提供了人体姿态估计的预训练模型,能够在视频生成过程中用于姿态指导。https://huggingface.co/yzd-v/DWPose

- MimicMotion 模型:用于生成高质量人体运动视频,结合自信度感知姿态引导,提高生成视频的细节和连续性。 https://huggingface.co/ixaac/MimicMotion/resolve/main/MimicMotion.pth

后面我们在comfyUI

使用时需要下载这几个模型

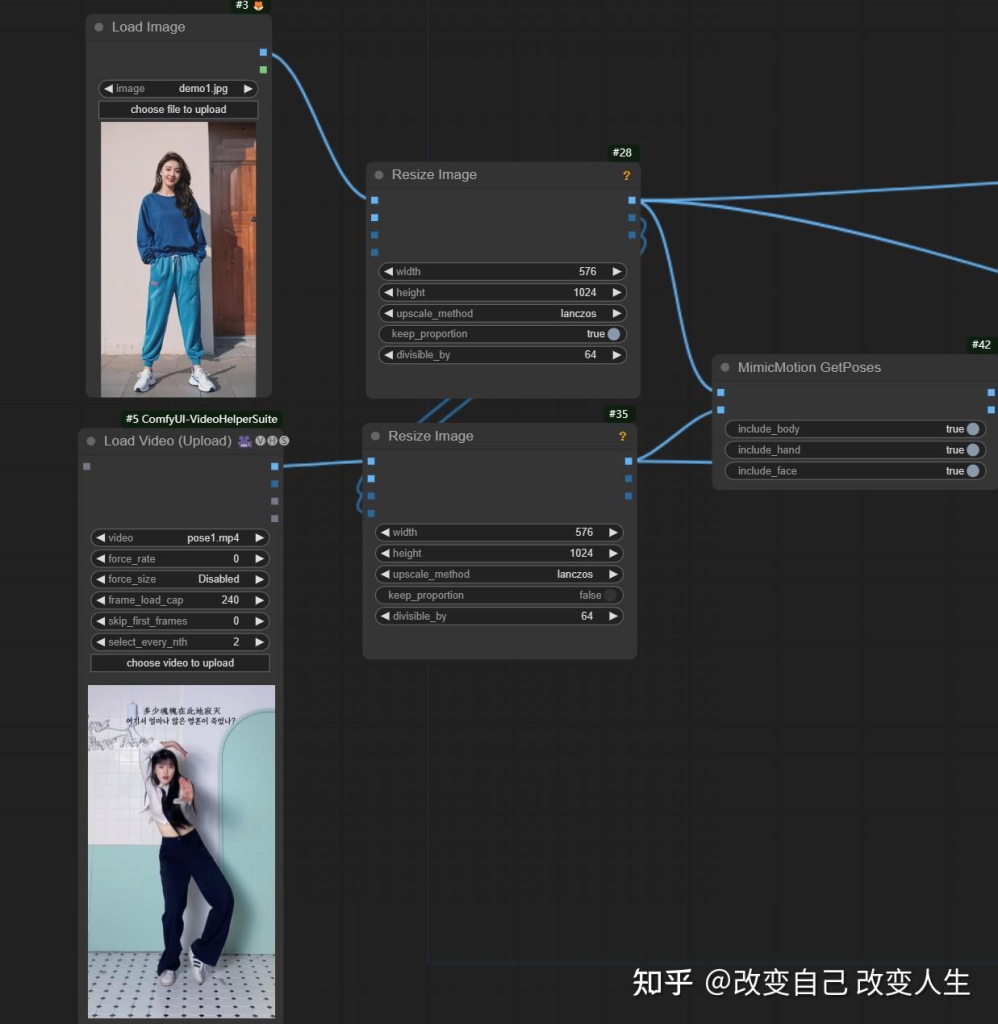

ComfyUI-MimicMotionWrapper的使用

1.首先下载节点

进入custom_nodes,使用

git clone GitHub - kijai/ComfyUI-MimicMotionWrapper

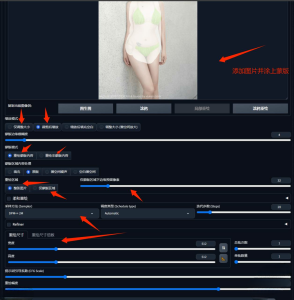

2. 重启服务器,把例子流程拉入comfyUI

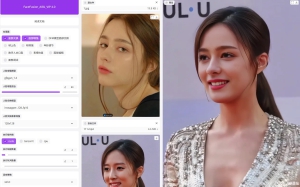

3. 选择示例video和照片

4. 运行

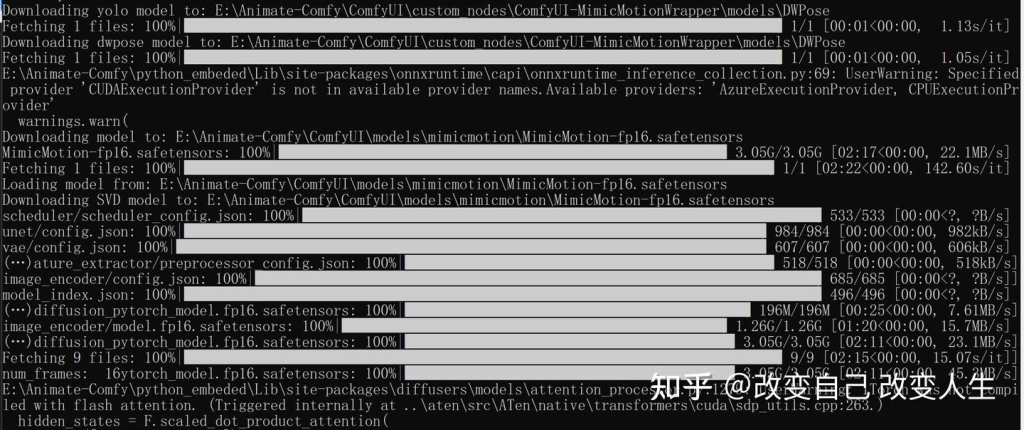

第一次运行会自动下载模型。这点需要吐槽一下,目前是直接下周几个模型,没有和已有的model里面的模型整合,可能是这个节点还在测试中的原因。

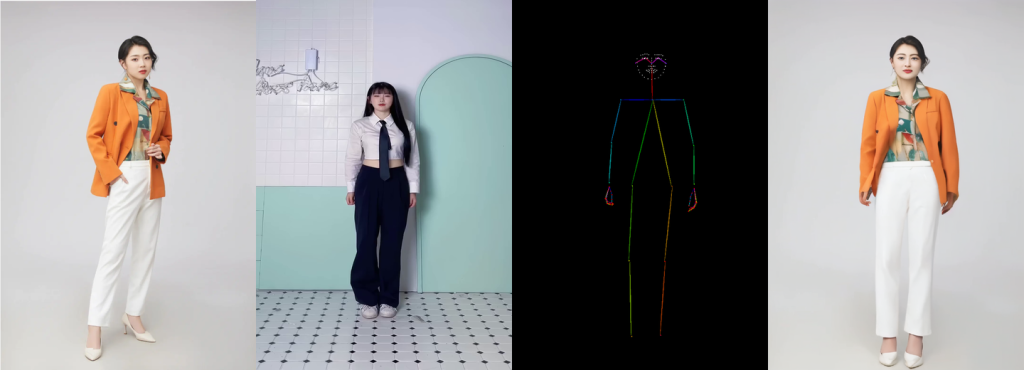

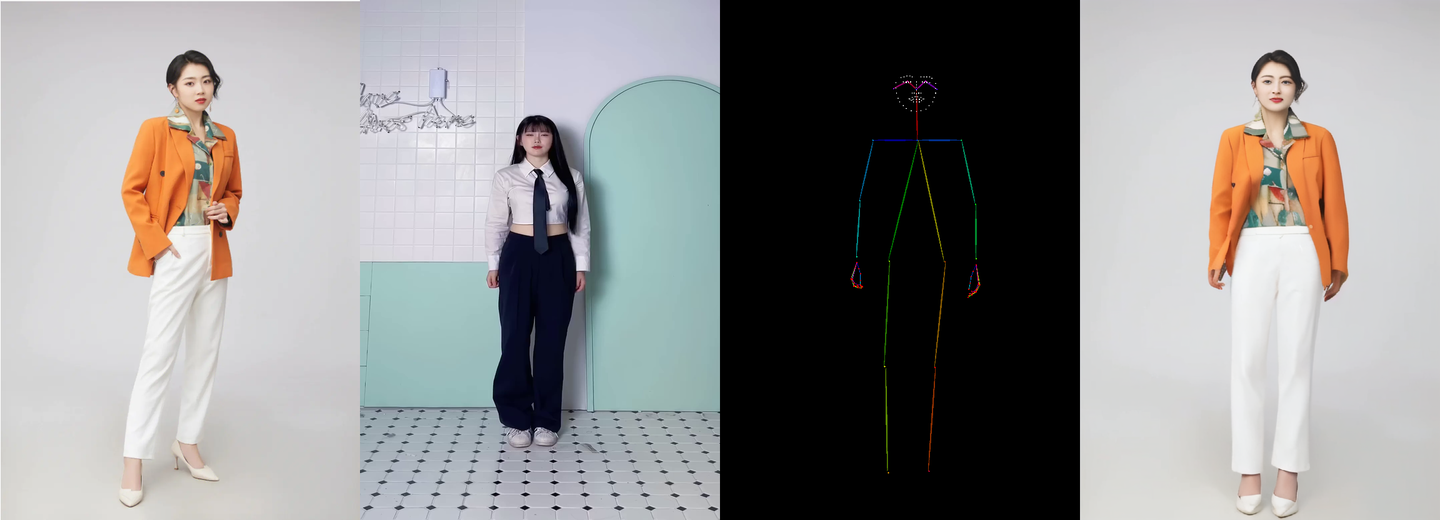

5.运行结果

运行速度还可以,120帧的视频4090显卡大概跑了十几分钟,结果如下

评价和结论

看效果,发现背景后面的门稍微有点晃动,人物面部和原来相似度并不好,但整体完成度,流畅性以及视频清晰度都超过过往几个模型。目前测试视频还不够多,只能说目前看结果相比几个其它模型

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

![[绘画教程] Comfyui,最强图片编辑模型轻松脱衣,支持50系列显卡-AIGC VIP部落](http://aigc.vvipblog.net/wp-content/uploads/2025/07/1752548383-61cd49faf155bb2-300x188.png)

暂无评论内容